|

|

|

Od abakusa do komputera

Wraz z pojawieniem się zapisu cyfrowego liczb i koniecznością dokonywania obliczeń matematycznych, począwszy od starożytności aż do czasów współczesnych wymyślane są coraz bardziej skomplikowane narzędzia do przetwarzania informacji (do rachowania).

|

|

|

|

Niewątpliwie pierwszym takim wynalazkiem był abakus (abak), używany przez starożytnych Egipcjan, Greków i Rzymian. Była to początkowo deska pokryta piaskiem, na której przeciągnięte zostały równoległe rysy. W utworzonych w ten sposób polach umieszczano kamienie: w pierwszej kolumnie oznaczały one jedności, w drugiej dziesiątki, w trzeciej setki, w czwartej tysiące itd. Później wygląd abakusów się zmieniał, jednak zasady posługiwania się nim były bardzo podobne. |

|

Obliczenia były wykonywane przez wkładanie i przekładanie kamyków, kulek albo żetonów umieszczonych w rowkach. Liczydło to późniejsza wersja abakusa, o takich samych możliwościach wykonywania działań. Za jego twórcę i propagatora uważany jest Gerbert z Aurillac, późniejszy papież Sylwester II, który korzystał z wiedzy o chińskich urządzeniach tego rodzaju. Zbudował nawet liczydło gigant z posadzki nawy katedralnej, obsługiwane przez 64 uczniów. |

|

Jeszcze do dziś spotkać można umieszczone w ramkach rzędy drewnianych, metalowych bądź plastikowych kulek, za pomocą których możliwe jest wykonywanie działań matematycznych, jak: dodawanie, odejmowanie czy mnożenie. Obecnie organizowane są nawet konkursy w rozwiązywaniu zadań (czasem bardzo skomplikowanych), a biegłość zawodników w posługiwaniu się liczydłem jest naprawdę imponująca. Dość powiedzieć, że jeszcze w połowie XX wieku sprawnie posługująca się liczydłem osoba wykonywała niektóre obliczenia szybciej niż elektryczna maszyna licząca. |

|

|

|

| Kolejnym wynalazkiem, który usprawnił proces liczenia, był suwak logarytmiczny – przyrząd rachunkowy działający na zasadzie dodawania logarytmów. Za odkrywcę logarytmów uważany jest szkocki baron John Napier i od tego momentu zaczęto układać pierwsze tablice logarytmiczne. Jak bardzo pracochłonne było to zadanie, niech świadczy fakt, że na początku XVII wieku Szwajcar Jost Buergi na sporządzone przez siebie tablice porzebował ośmiu lat żmudnych obliczeń polegających na mnożeniu wielkich liczb. Korzystanie z tablic było więc i pracochłonne, i kłopotliwe. W 1620 roku angielski matematyk Edmund Gunter odkrył skalę logarytmiczną, na której kreski podziałki nie są położone w równych odstępach, lecz w odstępach proporcjonalnych do logarytmów kolejnych liczb. Tę właśnie skalę wykorzystał inny matematyk angielski William Oughtred do stworzenia suwaka logarytmicznego. |

|

|

| Umieścił więc na dwu listewkach skalę logarytmiczną i skalę równomierną i zamocował te listewki w obudowie tak, by jedna z nich mogła się przesuwać wzdłuż drugiej. W ten sposób za pomocą odpowiedniego przesuwania względem siebie obu tych skal i dodawania różnej długości zaznaczonych na nich odcinków możliwe stało się szybkie mnożenie, dzielenie, potęgowanie i pierwiastkowanie zarówno liczb całkowitych, jak i ułamkowych. I to bez wykonywania żadnych skomplikowanych obliczeń, wystarczyło tylko odczytać wartości ze skali suwaka. W ówczesnych czasach suwak logarytmiczny przyjęty został z entuzjazmem i uważany był za epokowy wynalazek, przyczynił się do rozwoju wielu dziedzin nauki, w których trzeba było wykonywać działania na dużych liczbach, np. astronomii. Nawet teraz przełom, jaki suwak spowodował w technice obliczeniowej, porównywany jest z wynalezieniem komputera w XX wieku. |

|

|

|

XVII wiek przyniósł również pierwsze mechaniczne urządzenia obliczeniowe. Prekursorem w tej dziedzinie był niemiecki astronom i matematyk Wilhelm Schickard. W 1623 roku zbudował on z drewna czterodziałaniową maszynę liczącą. Maszyna ta nazywana była również zegarem liczącym, wykorzystywała bowiem mechanizmy zegarowe – tryby, koła, których ruchy są od siebie wzajemnie uzależnione. Pełny obrót koła o nominałach od 0 do 9 powodował mechaniczne przesunięcie się koła zawierającego jednostki wyższego rzędu (dziesiątki) o 1 itd. Na podobnej zasadzie działały także inne ówczesne maszyny liczące. Do obecnych czasów nie zachował jedyny wykonany egzemplarz maszyny Schickarda, |

|

który spłonął w 1624 roku. W 1960 roku próbowano ją odtworzyć na podstawie opisów i szkicu zawartych w listach Schickarda do wybitnego astronoma Johannesa Keplera.

Nieco później – w 1642 roku Blaise Pascal zbudował dwudziałaniową (dodawanie i odejmowanie) maszynę arytmetyczną. Miała ona ułatwić obliczanie podatków jego ojcu, który był królewskim radcą podatkowym. W sumie powstało 16 takich maszyn. 30 lat później natomiast Gottfried Wilhelm Leibniz, idąc śladami Pascala, zbudował arytmometr, za pomocą którego można było już wykonywać cztery działania matematyczne. Skonstruował on cztery egzemplarze tego urządzenia. Do naszych czasów zachował się oryginał arytmometru Leibniza, który został odnaleziony w 1879 roku na strychu w Getyndze i obecnie przechowywany jest w muzeum Leibniza w Hanowerze. |

|

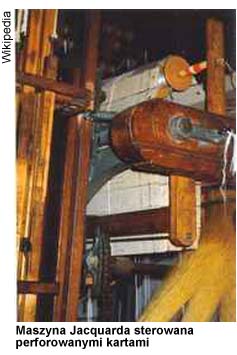

| Przełom w rozwoju maszyn liczących nastąpił w 1801 roku, gdy na wystawie w Paryżu pokazany został wynalazek tkacza francuskiego Josepha-Marie Jacquarda. Użył on do sterowania krosnem tkackim kart dziurkowanych z zakodowanym wzorem, który miał być tkany. Zapoczątkował tym samym automatyzację procesu przetwarzania danych. W późniejszych latach perforowane karty Jacquarda zostały zastosowane m.in. do zapisywania muzyki odgrywanej za ich pomocą przez automatyczne pianina oraz do przechowywania programów komputerowych. |

|

|

|

Ten sposób sterowania maszyną wykorzystał angielski matematyk Charles Babbage i wymyślił maszynę różnicową. Swojego projektu nigdy do końca nie zrealizował. Zrealizowali go za to na podstawie oryginalnych planów w latech 80. XX wieku pasjonaci techniki z Muzeum Nauki w Londynie. Pierwsza seria obliczeń za pomocą zrekonstruowanej maszyny została wykonana w latach 90. ubiegłego wieku i otrzymano wyniki z dokładnością do 31 cyfr. Drobną wadą urządzenia jest jednak fakt, że każde obliczenie wymaga, żeby użytkownik kręcił korbą kilkaset albo nawet kilka tysięcy razy... Po zawieszeniu prac nad maszyną różnicową Babbage przystępuje do nowego, doskonalszego modelu. Konstruuje maszynę analityczną. Był to historycznie pierwszy projekt maszyny matematycznej odpowiadający w swej strukturze współczesnej elektronicznej maszynie cyfrowej. Miała być ona wyposażona w arytmometr (sterowany za pomocą kart perforowanych), |

|

| w pamięć o pojemności do tysiąca liczb po pięćdziesiąt cyfr dziesiętnych i w urządzenie do wczytywania kart perforowanych. Co ciekawe, całość miała być napędzana za pomocą pary. Ciekawostką może być również fakt, że z Babbage'em współpracowała Ada Lovelace (córka angielskiego poety Lorda Byrona), której przypisuje się pomysł tworzenia wymiennych programów dla automatycznych maszyn liczących. Dodajmy jeszcze, że maszyna analityczna, podobnie jak jej poprzedniczka – maszyna różnicowa, nigdy nie została przez Babbage'a do końca zbudowana, pracował nad nią aż do swojej śmierci. |

|

| Kolejny ważny okres w rozwoju automatycznych maszyn cyfrowych przypada na czas II wojny światowej. Wtedy to wraz z postępem techniki wojskowej powstało zapotrzebowanie na szybko liczące maszyny cyfrowe. Pierwsze elektroniczne urządzenie liczące sterowane za pomocą programu skonstruował w 1941 roku niemiecki inżynier Konrad Zuse. Jego maszyna Z3 została zbudowana z zastosowaniem przekaźników elektromagnetycznych. Interesujące jest, że podczas wojny z powodu braku papieru Zuse wybijał otworki w starych taśmach filmowych i |

|

|

|

| w ten właśnie sposób przechowywał swoje programy i dane. Maszyna Z3 nie przetrwała wojny, została zniszczona podczas alianckiego bombardowania w 1944 roku (po wojnie ją zrekonstruowano). Ocalał jednak późniejszy model Z4, który został ukryty w jaskini w Alpach Bawarskich. Po wojnie zakupił go jeden z banków Zurychu, gdzie działał bezbłędnie przez kilka lat jako jedyny w tym czasie komputer na kontynencie europejskim. Obecnie znajduje się on w muzeum techniki w Monachium. Mniej więcej w tym samym czasie w Stanach Zjednoczonych, w 1944 roku, uruchomiona została pierwsza uniwersalna automatyczna maszyna cyfrowa o nazwie Mark I. Jej konstruktorem był fizyk amerykański Howard Aiken. |

|

|

|

Była to podobie jak Z3 maszyna przekaźnikowa, składała się z 755 000 elementów, miała wymiary ok. 15 m szerokości i 2,4 m wysokości i ważyła około 5 ton. Wykonywała ona trzy operacje dodawania na 1 s, jedno mnożenie trwało 6 s, a jedno dzielenie – 15 s. Maszyna mogła zapamiętywać 72 liczby 23-cyfrowe. Mark I uważany jest za pierwszy cyfrowy komputer, choć jego budowa znacznie różni się od tych stosowanych obecnie. |

|

| 1946 rok – to data zbudowania pierwszej na świecie maszyny cyfrowej z zastosowaniem techniki elektronicznej, do jej budowy użyto 18 tysięcy lamp elektronowych. ENIAC (Electronic Numerical Integrator and Computer) został skonstruowany przez Amerykanów Johna Mauchly'ego i Johna Eckerta. Pamięć maszyny mieściła 20 liczb 10-cyfrowych, a szybkość pracy wynosiła 5 tysięcy operacji dodawania na 1 s i 300-500 operacji mnożenia na 1 s. Urządzenie ważyło 15 ton i miało wymiary 15 na 9 metrów. Od tego momentu zacznają powstawać nowe komputery (EDVAC, EDSAC, UNIVAC), które korzystają z doświadczeń przy projektowaniu ENIAC-a. Szczególne znaczenie przy ich budowie miały prace amerykańskiego matematyka pochodzenia węgierskiego Johanna von Neumanna. |

|

| W książce „Pierwszy szkic raportu na temat komputera EDVAC” przedstawił teoretyczne podstawy budowy i działania komputerów, które są aktualne do dziś. Jako pierwszy wprowadził on podział komputera na trzy podstawowe części: 1. pamięć operacyjna (zawierająca dane i program); 2. procesor (układ sterowania, jednostka arytmetyczno-logiczna); 3. urządzenia wejścia/wyjścia (urządzenia peryferyjne). Ciekawostką jest fakt, że Neumann przed II wojną światową przebywał w Polsce, gdzie zapoznawał się z osiągnięciami znanej na całym świecie polskiej szkoły |

|

|

|

matematycznej. Próbował nawet bez powodzenia namówić wybitnego polskiego matematyka Stefana Banacha do wyjazdu do Stanów Zjednoczonych i podjęcia tam pracy naukowej.

|

|

Kolejnym ważnym etapem w rozwoju komputerów było wynalezienie tranzystora, a niedługo później – układów scalonych. Spowodowało to podniesienie wszystkich parametrów komputera: zmniejszenie jego wagi i wymiarów, zwiększenie pamięci oraz szybsze wykonywanie operacji. Wszystko to nie zmieniło jednak sytuacji, że komputery przez cały ten czas były używane jedynie przez duże instytucje, centra naukowe itp. Dopiero wynalezienie mikroprocesora w 1971 roku zmieniło ten stan rzeczy. Niedługo potem powstały pierwsze modele mikrokomputerów, będących przedmiotem codziennego użytku. Ich wygląd i możliwości operacyjne znacznie odbiegały od tych używanych dziś. Zapoczątkowały jednak okres, w którym komputer jest obecny niemal w każdym domu.

(dt) |

|

|

|

|